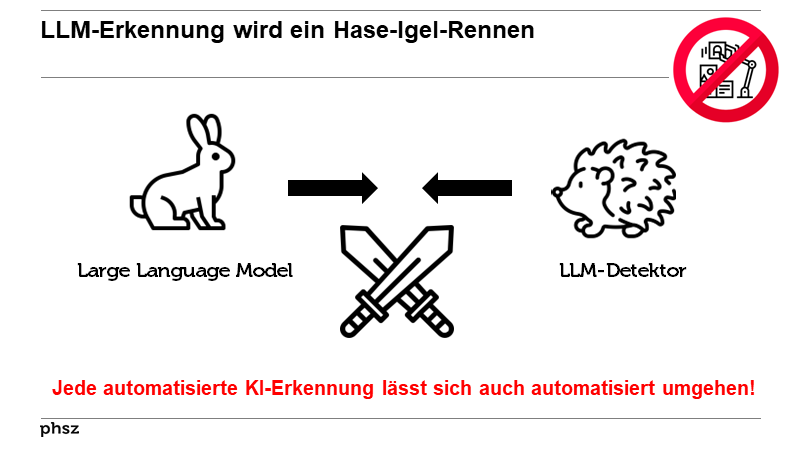

Jede automatisierte KI-Erkennung lässt sich auch automatisiert umgehen

Definitions

Definitions

Wenn aber ein Algorithmus in der Lage ist, automatisch zu erkennen, ob ein Text von einem Menschen oder von einer Maschine geschrieben wurde, dann ist es auch möglich, eine Maschine zu bauen, die ihre Texte so formuliert, dass ein Detektor keinen Unterschied bemerkt.

Wenn aber ein Algorithmus in der Lage ist, automatisch zu erkennen, ob ein Text von einem Menschen oder von einer Maschine geschrieben wurde, dann ist es auch möglich, eine Maschine zu bauen, die ihre Texte so formuliert, dass ein Detektor keinen Unterschied bemerkt. Comments

Comments

Bücher first.

Unerfreuliches Fazit: Durch KI generierte Texte sind nicht

justizfest zu entlarven.

From Günther Hoegg in the text Kann man KI entlarven? (2025)  Forschende gehen von einem Wettlauf zwischen KI-Systemen

zur Erzeugung und solchen zur Entdeckung künstlicher Texte aus (Heidt

2023).

Forschende gehen von einem Wettlauf zwischen KI-Systemen

zur Erzeugung und solchen zur Entdeckung künstlicher Texte aus (Heidt

2023).Die meisten Forscher halten es jedoch für eine trügerische Hoffnung, dass die Herkunft eines mit Künstlicher Intelligenz (KI) generierten Textes technisch leicht erkennbar bleibt.

From Heike Schmoll in the text Hausaufgaben machen mit ChatGPT? (2023)

Obwohl LLMs einen elaborierten Schreibstil noch nicht perfekt imitieren können, ist also zu erwarten, dass natürliche und künstliche Texte nunterscheidbar werden und der hybride Text zur Norm wird.

Mike Sharples hält den Kampf gegen

KI-Texte mit technischen Mitteln für vergeblich: «Jedes hinreichend leistungsfähige

Programm, das feststellen

kann, ob ein Text von einem Menschen

oder einer Maschine geschrieben wurde,

kann von einem ebenso leistungsfähigen

KI-Textgenerator in einem sinnlosen

rechnerischen Wettrüsten überlistet

werden.»

Mike Sharples hält den Kampf gegen

KI-Texte mit technischen Mitteln für vergeblich: «Jedes hinreichend leistungsfähige

Programm, das feststellen

kann, ob ein Text von einem Menschen

oder einer Maschine geschrieben wurde,

kann von einem ebenso leistungsfähigen

KI-Textgenerator in einem sinnlosen

rechnerischen Wettrüsten überlistet

werden.» Der Untergang der klassischen Ghostwriter-Szene und der Anbieter von Plagiaterkennungssoftware ist wohl schon eingeläutet. Ein unvorstellbar mächtiges KI-Sprachmodell mit 175 Milliarden Parametern und dem sperrigen Namen „Generative Pretrained Transformer Model“ (kurz: GPT) von OpenAI aus San Francisco zeigt seine Sprengkraft immer deutlicher (aktuelle Version 3).

Der Untergang der klassischen Ghostwriter-Szene und der Anbieter von Plagiaterkennungssoftware ist wohl schon eingeläutet. Ein unvorstellbar mächtiges KI-Sprachmodell mit 175 Milliarden Parametern und dem sperrigen Namen „Generative Pretrained Transformer Model“ (kurz: GPT) von OpenAI aus San Francisco zeigt seine Sprengkraft immer deutlicher (aktuelle Version 3).Leider wird es noch schlimmer: Um die Detektoren vollständig

auszuhebeln, gibt es inzwischen KI-Humanizer. Diese

kontrollieren kostenlos Ihren durch KI generierten Text, um

zu prüfen, ob er durch einen Detektor entlarvt werden kann.

Dreimal dürfen Sie raten, wie das Ergebnis aussieht. Richtig.

Denn danach bietet man Ihnen sogleich an, Ihren Text (jetzt

kostenpflichtig) so zu optimieren, dass er nicht mehr als künstlicher

zu erkennen ist.

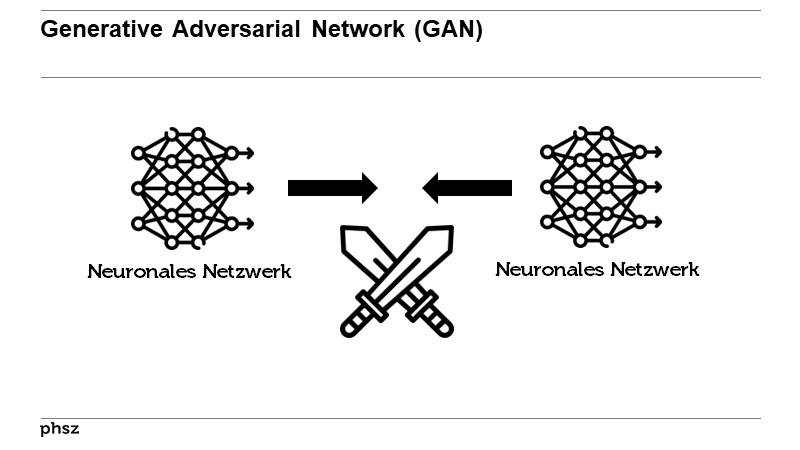

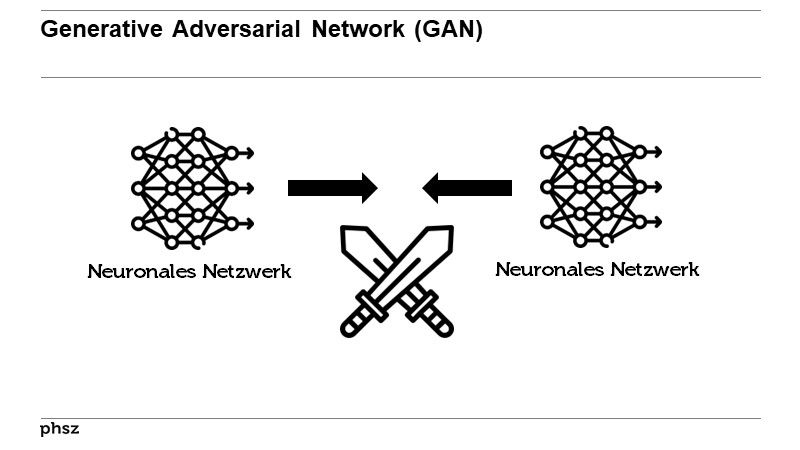

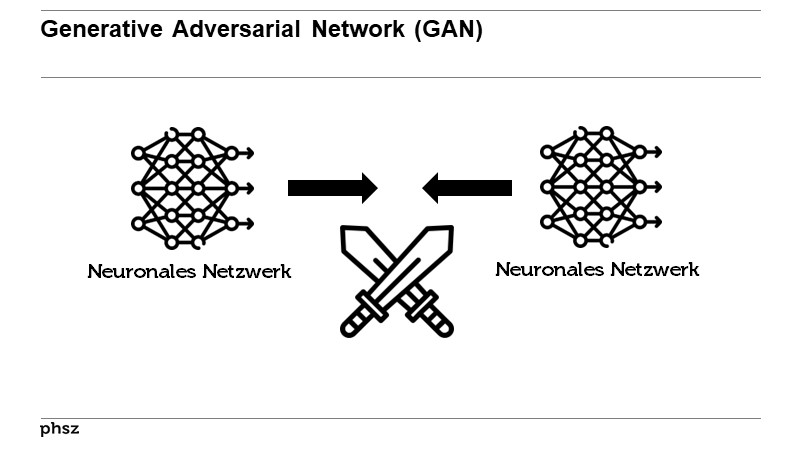

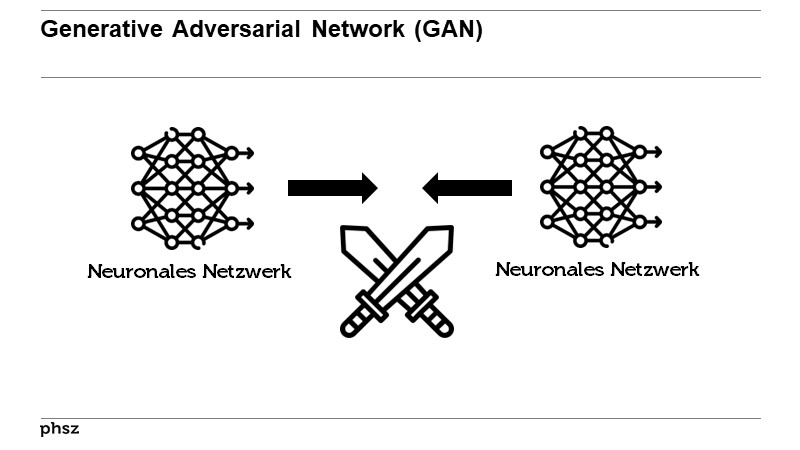

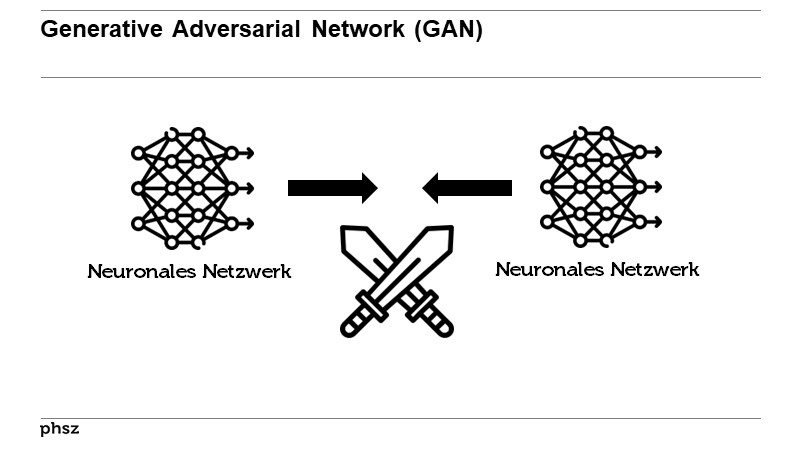

From Günther Hoegg in the text Kann man KI entlarven? (2025)  Die Entwicklung von Programmen zur Erkennung von KI-generierten Texten (wie z.B. GPT-Zero) wird ein Wettrüsten zwischen KI-Textgenerierung und KI-Texterkennung auslösen, da KI-Textgenerierungsprogramme die verfügbaren Erkennungsprogramme als zusätzlichen Filter / Trainingsmöglichkeit nutzen werden (GAN-Netzwerk mit Erkennungsalgorithmus als Diskriminator). Es wird somit vermutlich langfristig nicht möglich sein, computergenerierte Texte zuverlässig automatisiert erkennen zu können.

Die Entwicklung von Programmen zur Erkennung von KI-generierten Texten (wie z.B. GPT-Zero) wird ein Wettrüsten zwischen KI-Textgenerierung und KI-Texterkennung auslösen, da KI-Textgenerierungsprogramme die verfügbaren Erkennungsprogramme als zusätzlichen Filter / Trainingsmöglichkeit nutzen werden (GAN-Netzwerk mit Erkennungsalgorithmus als Diskriminator). Es wird somit vermutlich langfristig nicht möglich sein, computergenerierte Texte zuverlässig automatisiert erkennen zu können.Besonders problematisch ist, dass KI-Prüfsoftware

manchmal Texte als Fälschung bewertet, die Schüler

ehrlich und ohne KI-Hilfe erstellt haben. Eine Studie

unter Beteiligung der Berliner Plagiatsforscherin

Debora Weber-Wulff fällt deshalb kein gutes Urteil

über KI-Detektoren. Manche maschinelle Auswertung

sei zwar brauchbar, Sicherheit jedoch biete sie

in keinem Fall. »Die Hoffnung, dass es eine einfache

Softwarelösung zum Enttarnen von KI-Texten gibt,

wird sich nicht erfüllen«, so Weber-Wulffs Urteil.

From Ulf Schönert in the text «Schreibe wie ein 15-Jähriger!» (2025) Doch die andere Seite rüstet ebenso technisch auf.

So wie es KI-Detektoren gibt, gibt es auch KI-Verschleierer,

Humanisierer genannt, sie heißen etwa

Humbot oder BypassGPT. »Vermenschlichen Sie Ihre

Inhalte, um sie nicht nachweisbar zu machen«, wirbt

rewritify.ai. Solche Dienste nehmen lediglich kleine

Textänderungen vor und lassen sie dann so lange von

unterschiedlichen KI-Detektoren prüfen, bis sie als

»menschlich« eingestuft werden. KI-Detektoren

gegen KI-Humanisierer: »Das ist wie ein Katz-und-

Maus-Spiel«, sagt Tlok.

From Ulf Schönert in the text «Schreibe wie ein 15-Jähriger!» (2025)  Wenn aber ein Algorithmus in der

Lage ist, automatisch zu erkennen, ob ein

Text von einem Menschen oder von einer

Maschine geschrieben wurde, dann ist es auch möglich, eine Maschine zu bauen,

die ihre Texte so formuliert, dass ein Detektor

keinen Unterschied bemerkt. Ähnliche

Funktionen sind bereits in die oben

genannten Marketing-Tools integriert. Sie

haben einen automatischen Plagiat-Checker

an Bord. Dieser prüft die generierten

Texte daraufhin, ob sie nicht Wort für

Wort irgendwo anders abgeschrieben

worden sind. Per KI lassen sich Texte

daraufhin

so lange umformulieren, bis der

Plagiat-Checker grünes Licht gibt.

Wenn aber ein Algorithmus in der

Lage ist, automatisch zu erkennen, ob ein

Text von einem Menschen oder von einer

Maschine geschrieben wurde, dann ist es auch möglich, eine Maschine zu bauen,

die ihre Texte so formuliert, dass ein Detektor

keinen Unterschied bemerkt. Ähnliche

Funktionen sind bereits in die oben

genannten Marketing-Tools integriert. Sie

haben einen automatischen Plagiat-Checker

an Bord. Dieser prüft die generierten

Texte daraufhin, ob sie nicht Wort für

Wort irgendwo anders abgeschrieben

worden sind. Per KI lassen sich Texte

daraufhin

so lange umformulieren, bis der

Plagiat-Checker grünes Licht gibt. Da sich die Qualität künstlich generierter Medien stetig verbessert, sind wir Menschen nicht mehr in der Lage, Deepfakes ohne Weiteres als solche zu erkennen, weshalb die Investition in KI-basierte Erkennungsprogramme durchaus sinnvoll ist. Doch dieser Ansatz hat natürlich auch seine Tücken. Die Erfassung von Deepfakes ist ein sich ständig weiterentwickelndes Katz-und-Maus-Spiel. Denn ebenso wie die Erkennungsprogramme werden natürlich auch Deepfakes immer besser. Rein theoretisch könnte die Qualität synthetisch generierter Medien sogar so gut werden, dass deren Erfassung unmöglich wird. Ob es wirklich so weit kommt, wird sich noch zeigen.

Da sich die Qualität künstlich generierter Medien stetig verbessert, sind wir Menschen nicht mehr in der Lage, Deepfakes ohne Weiteres als solche zu erkennen, weshalb die Investition in KI-basierte Erkennungsprogramme durchaus sinnvoll ist. Doch dieser Ansatz hat natürlich auch seine Tücken. Die Erfassung von Deepfakes ist ein sich ständig weiterentwickelndes Katz-und-Maus-Spiel. Denn ebenso wie die Erkennungsprogramme werden natürlich auch Deepfakes immer besser. Rein theoretisch könnte die Qualität synthetisch generierter Medien sogar so gut werden, dass deren Erfassung unmöglich wird. Ob es wirklich so weit kommt, wird sich noch zeigen. Wird es künftig möglich sein, menschliche

und KI-generierte Texte zu unterscheiden?

Die Erwartung, dass das Kriterium

sprachlicher Unvorhersehbarkeit

zur Unterscheidung beitragen könnte

(Hannes Bajohr), erweist sich als trügerisch.

Erstens beruht sämtliche Prosa

auf „wiederholter Rede“, die erfahrene

Schreiber durch einige regelhaft beschreibbare

Analogien und Deviationen

anreichern. Zweitens sind LLMs auch

kreativen Sprachgebrauchs fähig. Es

wäre falsch anzunehmen, wie in den

Medien häufig durch das Bild des stochastischen

Papageis suggeriert wurde,

dass LLMs lediglich Wörter nach ihrer

Auftretenswahrscheinlichkeit kombinieren;

vielmehr können sie auch Konstruktionen

analysieren und auf dieser

Basis akzeptable neue Formen erzeugen.

Wird es künftig möglich sein, menschliche

und KI-generierte Texte zu unterscheiden?

Die Erwartung, dass das Kriterium

sprachlicher Unvorhersehbarkeit

zur Unterscheidung beitragen könnte

(Hannes Bajohr), erweist sich als trügerisch.

Erstens beruht sämtliche Prosa

auf „wiederholter Rede“, die erfahrene

Schreiber durch einige regelhaft beschreibbare

Analogien und Deviationen

anreichern. Zweitens sind LLMs auch

kreativen Sprachgebrauchs fähig. Es

wäre falsch anzunehmen, wie in den

Medien häufig durch das Bild des stochastischen

Papageis suggeriert wurde,

dass LLMs lediglich Wörter nach ihrer

Auftretenswahrscheinlichkeit kombinieren;

vielmehr können sie auch Konstruktionen

analysieren und auf dieser

Basis akzeptable neue Formen erzeugen.Do AI detectors work?

From OpenAI in the text How can educators respond to students presenting AI-generated content as their own? (2023) - In short, no, not in our experience. Our research into detectors didn't show them to be reliable enough given that educators could be making judgments about students with potentially lasting consequences.While other developers have released detection tools, we cannot comment on their utility.

- Additionally, ChatGPT has no “knowledge” of what content could be AI-generated. It will sometimes make up responses to questions like “did you write this [essay]?” or “could this have been written by AI?” These responses are random and have no basis in fact.

- To elaborate on our research into the shortcomings of detectors, one of our key findings was that these tools sometimes suggest that human-written content was generated by AI.

- When we at OpenAI tried to train an AI-generated content detector, we found that it labeled human-written text like Shakespeare and the Declaration of Independence as AI-generated.

- There were also indications that it could disproportionately impact students who had learned or were learning English as a second language and students whose writing was particularly formulaic or concise.

- Even if these tools could accurately identify AI-generated content (which they cannot yet), students can make small edits to evade detection.

10 Talks by Beat mentioning

10 Talks by Beat mentioning

- ChatGPT - der iPhone-Moment für KI?

Klausur PHSZ, Oberägeri, 14.02.2023

- ChatGPT - der iPhone-Moment des maschinellen Lernens

NMS Bern, 07.06.2023

- KVreform GPT

Kaufmännische Berufsschule Schwyz, 05.07.2023

- BBZGPT

Berufsbildungszentrum Goldau, 17.08.2023

- ChatGPT & Co. – eine Etappe auf der Reise nach Digitalien

CAS Lernreise, 19.01.2024

- Wenn ChatGPT in der Lehrer:innenbildung mitredet

(Video des Referats)

Tag der Lehre der PHZH, 01.02.2024

- Was will uns ChatGPT sagen?

8. Pädagogischer Dialog Liechtenstein, Vaduz, 21.02.2024

- Sprachmaschinen.

Deutschsprachige AG Fremdsprachen der EDK, PHZH, 20.03.2024

- Überfluten uns ChatGPT & Co.?

Tagung des Berufsverbands Schulleitungen Bern

Schwellenmätteli Bern, 24.05.2024

- Zwischen Experimentierfreude und Überforderung

Kaderanlass, Schulkreis Uto Zürich, 03.06.2025

Citation Graph

Citation Graph

Citation Graph(Beta-Test mit vis.js)

Citation Graph(Beta-Test mit vis.js)

Timeline

Timeline

21 References

21 References

- Deepfakes - Wie gefälschte Botschaften im Netz unsere Demokratie gefährden und unsere Leben zerstören können (Nina Schick) (2020)

- 7. Gleichgesinnte, vereinigt euch!

- Das Ende der Hausarbeit (Susanne Bach, Doris Weßels) (2022)

- ChatGPT & Schule - Einschätzungen der Professur „Digitalisierung und Bildung“ der Pädagogischen Hochschule Schwyz (Beat Döbeli Honegger) (2023)

- Hinweise zu textgenerierenden KI-Systemen im Kontext von Lehre und Lernen (Beatrix Busse, Ingo Kleiber, Franziska C. Eickhoff, Kathrin Andree) (2023)

- Der universelle Texter - Warum ChatGPT so fasziniert (Themen-Special von c't 05/23 (2023)

- Wer soll das alles lesen? - KI-Textgeneratoren überschwemmen das Internet (Hartmut Gieselmann)

- Wer soll das alles lesen? - KI-Textgeneratoren überschwemmen das Internet (Hartmut Gieselmann)

- Wie ChatGPT die Schule verändern wird (Jochen Zenthöfer) (2023)

- Artifizielle und postartifizielle Texte - Über die Auswirkungen Künstlicher Intelligenz auf die Erwartungen an literarisches und nichtliterarisches Schreiben (Hannes Bajohr) (2023)

- info7 1/2023 - Das Magazin für Medien, Archive und Information (2023)

- Yes, We Are in a (ChatGPT) Crisis (Inara Scott) (2023)

- Jede Lehrkraft muss ChatGPT kennen (Lisa Becker) (2023)

- ChatGPT und andere Computermodelle zur Sprachverarbeitung - Grundlagen, Anwendungspotenziale und mögliche Auswirkungen (Steffen Albrecht) (2023)

- Hausaufgaben machen mit ChatGPT? (Heike Schmoll) (2023)

- ChatGPT & Co. - Mit KI-Tools effektiv arbeiten (2023)

- Wer soll das alles lesen? - KI-Textgeneratoren überschwemmen das Internet (Hartmut Gieselmann)

- Wer soll das alles lesen? - KI-Textgeneratoren überschwemmen das Internet (Hartmut Gieselmann)

- Testing of Detection Tools for AI-Generated Text (Debora Weber-Wulff, Alla Anohina-Naumeca, Sonja Bjelobaba, Tomáš Foltýnek, Jean Guerrero-Dib, Olumide Popoola, Petr Šigut, Lorna Waddington) (2023)

- Forschung & Lehre 7/23 (2023)

- Vom Akkordarbeiter zum Gutachter (Dirk Siepmann) (2023)

- Vom Akkordarbeiter zum Gutachter (Dirk Siepmann) (2023)

- c't 21/2023 (2023)

- Die 80-Prozent-Maschinen - Warum KI-Sprachmodelle weiterhin Fehler machen und was das für den produktiven Einsatz bedeutet (Hartmut Gieselmann) (2023)

- Die 80-Prozent-Maschinen - Warum KI-Sprachmodelle weiterhin Fehler machen und was das für den produktiven Einsatz bedeutet (Hartmut Gieselmann) (2023)

- Künstliche Intelligenz, Large Language Models, ChatGPT und die Arbeitswelt der Zukunft (Michael Seemann) (2023)

- How can educators respond to students presenting AI-generated content as their own? (OpenAI) (2023)

- Künstliche Intelligenz - Mehr als nur ein Hype? - Bildungsbeilage der NZZ vom 22.11.2023 (2023)

- Darf der Computer die Seminararbeit schreiben? (Reto U. Schneider)

- Darf der Computer die Seminararbeit schreiben? (Reto U. Schneider)

- Pädagogik 3/2025 (2025)

- Kann man KI entlarven? (Günther Hoegg) (2025)

- «Schreibe wie ein 15-Jähriger!» (Ulf Schönert) (2025)

Search at other places

Search at other places

Biblionetz-History

Biblionetz-History

Webzugriffe

Biblionetz-Verweise auf 'Jede automatisierte KI-Erkennung lässt sich auch automatisiert umgehen'

Biblionetz-Verweise auf 'Jede automatisierte KI-Erkennung lässt sich auch automatisiert umgehen'

QR-Code dieser Seite

QR-Code dieser Seite